피드포워드 네트워크 (Feed-Forward Networks)

- 2개의 전 결합층 (dense layer)과 ReLU 활성화 함수로 구성

- 피드 포워드 네트워크의 변수는 문장의 다른 위치에서는 동일하고 인코더 블럭에서는 다르게 나타낸다

add와 norm 요소

인코더에서 중요한 요소 중 하나는 바로 add와 norm 관련 부분이다. 이 부분은 서브레이어의 입력과 출력 부분에 연결되어 있다.

- 서브레이어에서 멀티헤드 어텐션의 입력값과 출력값은 서로 연결한다

- 서브레이어에서 피드포워드의 입력값과 출력값을 서로 연결한다

add와 norm 요소는 기본적으로 레이어 정규화 (layer normalization)의 잔차 연결 (residual connection)이다

Residual Connection

- 특정 레이어를 건너 뛰어서 입력

- 초기의 모델 수렴 속도가 높아진다

- 입력 데이터와 self-Attention의 결과를 더함

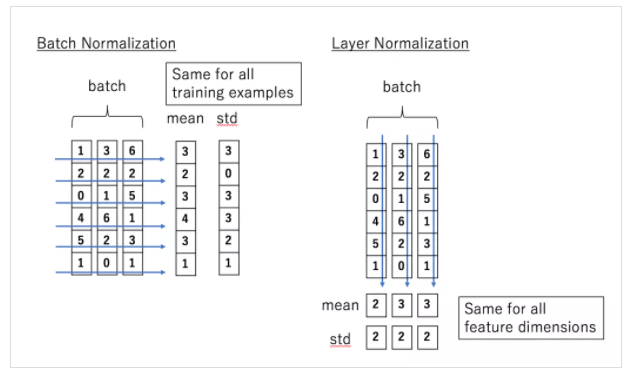

Layer normalization

- 각 레이어 값이 크게 변화하는 것을 방지해 모델을 더 빠르게 학습

- residual connection 결과에 대한 정규화 진행

레이어 정규화는 각 레이어 값이 크게 변화하는 것을 방지해 모델을 더 빠르게 학습할 수 있게 한다.

'Machine-Learning > NLP (Natural Language Processing)' 카테고리의 다른 글

| [NLP] Transforemr decoder 이해 (0) | 2022.11.15 |

|---|---|

| [NLP] 멀티 헤드 어텐션(multi-head attention) 원리 (2) | 2022.11.06 |

| [NLP] Transformer - positional encoding, self-attention (0) | 2022.10.11 |

| [NLP] Transformer-Overview (0) | 2022.10.11 |

| [NLP] Seq2Seq (0) | 2022.10.04 |

댓글